Wie immer gilt: Nicht „blind“ kaufen, sondern Preise vergleichen – am besten die von vor einigen Monaten. Erst Preise erhöhen, um dann dicke Rabatte ankündigen zu können soll es ja geben. Davon abgesehen alle Angaben nach besten Wissen und Gewissen aber ohne Garantie.

Der Dauerbrenner: Adobe-Produkte

Direkt bei Adobe gibt es für Einsteiger 50% Rabatt auf’s Jahresabo für die große Suite mit allen Apps für’s erste Jahr – die Aktion gilt bis 28. November. Danach werden die üblichen, recht happigen Preise fällig aber es gibt immer wieder Sonderangebote, mit denen man 1 Jahr Abo im voraus günstig erwerben kann und die normale Adobezahlung wird dann ausgesetzt.

Das LR-Abo mit 20 GB gibt es allerdings nicht mehr für Neukunden und auch keine Prepaid-Codes mehr. Entweder man zahlt direkt bei Adobe weiter oder man steigt auf die 1 TB Version um, für die es (erstmal?) auch weiter Sonderangebote gibt. Aber Achtung

Das günstigste habe ich bei https://www.cyberport.de gefunden – 370€ die komplette Suite, Foto-Abo 89 €, LR sogar nur 49 €. Schüler/Studis/Lehrkräfte 79 € für die komplette Suite.

Bei den Angeboten erhält man einen Code der wie nachfolgend skizziert bei Adobe eingelöst werden kann. Achtung – es gibt auch sogenannte Volumenlizenzen, die teils günstiger sind aber dafür mehr Berichte von Problemen mit den Anbietern …

Ihr bekommt einen „Redeem-Code“ (direkt in der Bestellbestätigung oder bei Amazon in der Softwarebibliothek – siehe Bild oben), den ihr unter https://redeem.adobe.com/ (oder https://redeem.adobe.com/educard im Falle der Students-Version) eingeben könnt.

Achtet darauf, dass über dem Zahlenfeld die Adobe-ID eures bestehenden Abos angezeigt wird falls ihr mehrere Accounts habt. Nach dem Einlösen könnt ihr im Adobe Konto nachschauen – dort steht dann zwar immer noch der übliche Monatspreis aber mit dem Vermerk „Nächste Zahlung am XXX“, sprich die Zahlungsabwicklung über Adobe ist in dem Abo für den Zeitraum des Kaufs über Amazon ausgesetzt.

Ihr könnt übrigens auch mehrere Jahresabos kaufen und in eurem Account hinterlegen – sinkende Preise sind ja an keiner Stelle zu erwarten.

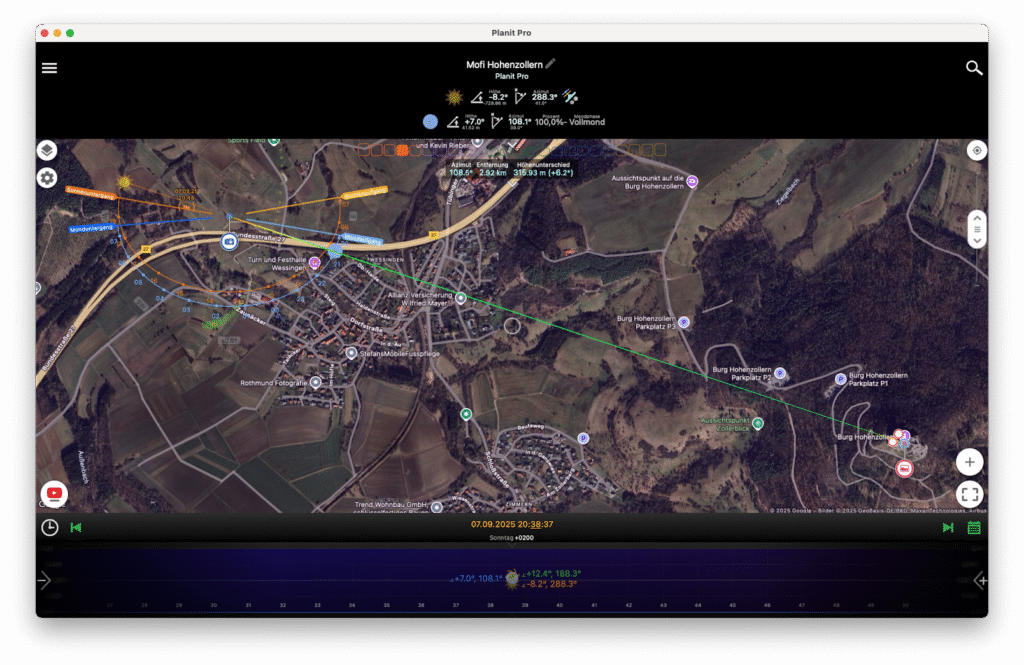

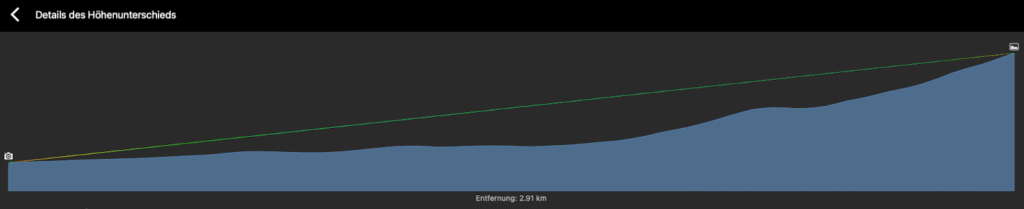

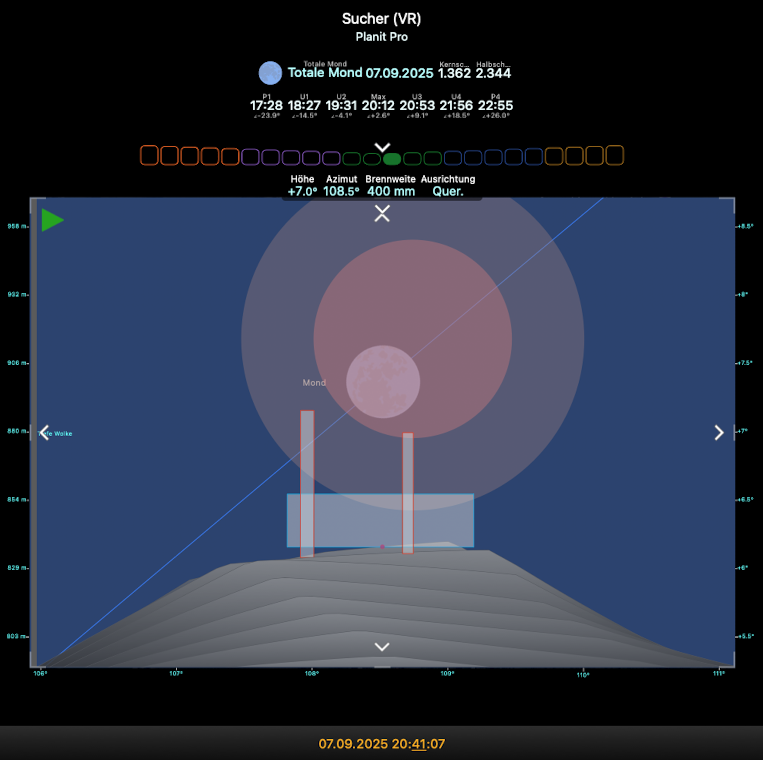

Neu 24.11. 25 % bei Black Forrst Motion

Link hinterm Bild oben, zum Review geht’s hier 🙂

Astrhori – bis zu 30% auf Objektive

Haben einige interessante Speziallinsen im Programm – die Topprodukte werden aber wohl eher nicht stark reduziert sein – gilt bis 1. Dezember unter https://www.astrhori.cn/

Neat Video – 15% Rabatt

Eine weitere fast unentbehrliche Software (bzw. Plugin für Premiere, Resolve & Co.) in Sachen Nachtzeitraffer ist Neat Video mit ausgezeichneter Rauschreduktion und Deflicker – sowohl zwischen Frames als auch für lokales Flicker (!): https://www.neatvideo.com/purchase

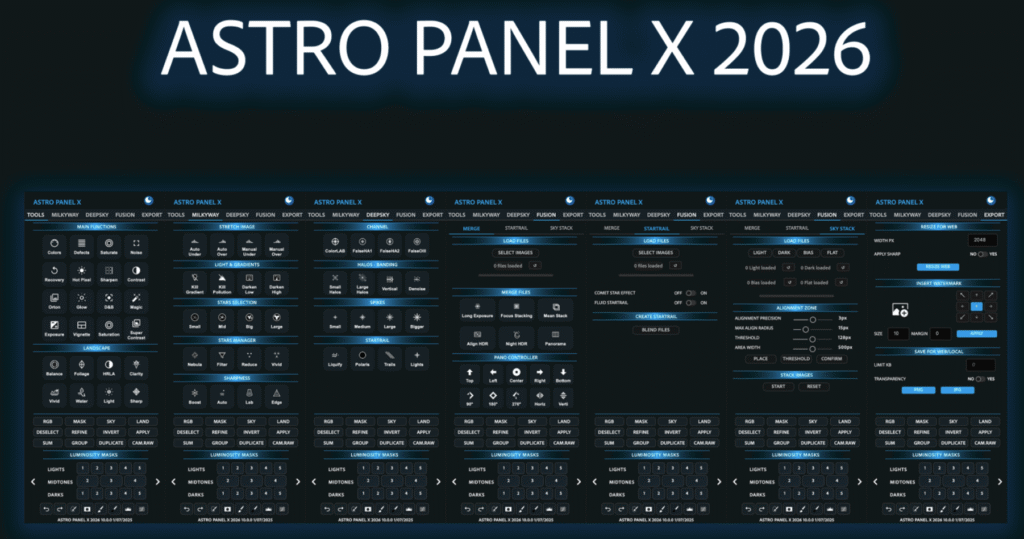

Astro Panel X2026

Photoshop Plugin speziell für die Bearbeitung von Astrobildern. Mit ap2026x50 unter https://astropanel.it 50% sparen 🙂 Gültigkeitsdauer unbekannt – aktuell kam BF2025 für den Black Friday mit 20% Rabatt.

Zu Fusion und Backgrundextraction kann ich nichts sagen – bei letzterem würde ich erstmal das kostenlose GraXpert empfehlen.

Edelkrone

Bei der „Edelschmiede“ in Sachen Motion Gear gibt’s im „Black November“ 30% Rabatt auf Alles – naja, alles was da ist zumindest. Außer Tiernahrung natürlich 😉 https://edelkrone.com/

Sirui – Stative, Objektive & mehr

Bis zu 74% heißt idR. arg viel suchen, bis irgendein komplett unwichtiges Teil tatsächlich so stark reduziert ist und es steht schon oft „ausverkauft“ bei den Produkten https://store.sirui.com/pages/sales-1

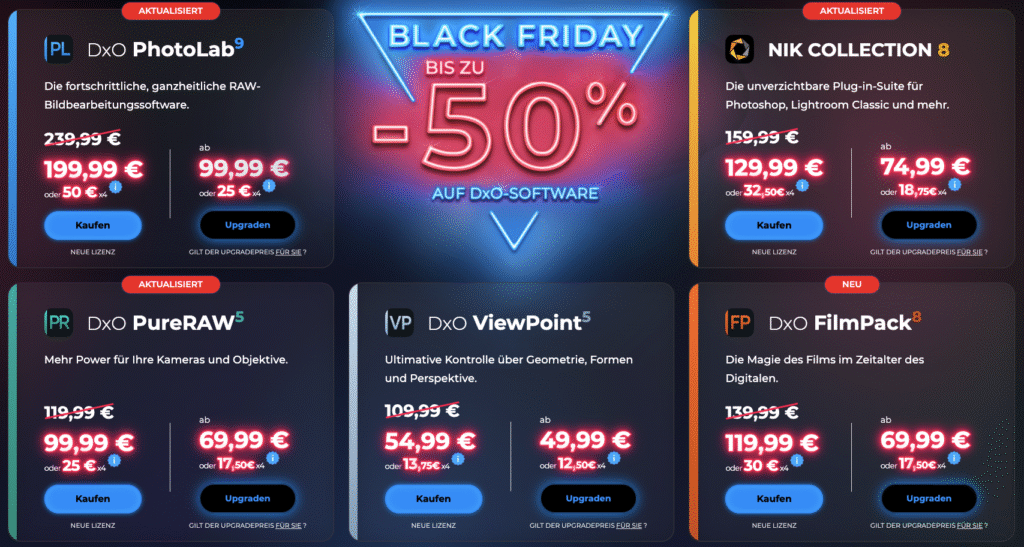

DxO Software mit „bis zu 50% Rabatt“ – stimmt immerhin bei einem Produkt 😉

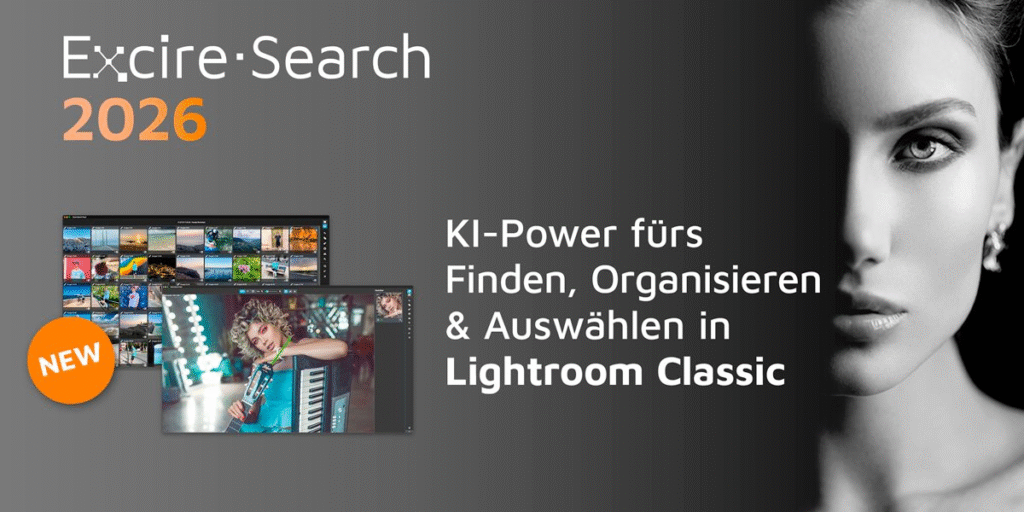

Excire 2026 – 30% Rabatt

Wer kennt es nicht – „Ich hab doch mal ein Bild von xy gemacht aber wo ist das nur?“ 😉 Neben strikter Orga der vielen Bilder hilft KI – die findet ähnliche Bilder, macht Gesichtserkennung, automatisches Tagging und Freitextsuche á la „zeige mir alle Bilder mit Vollmond bei Tageslicht“.

Das Ganze gibt’s als Standalone Fotoverwaltung oder als PlugIn für Lightroom und vom 28.11. bis 7.12. 30% günstiger! Einfach https://excireeu.pxf.io/jevGze anklicken und BF-EXCIRE-30 beim Checkout nutzen!

Kase-Filter

Was es wirklcih sinnvolles deutlich reduziert gibt, muss man schauen und dann gibt’s noch 10 € für Newsletteranmeldung …

Baader Planetarium – 20% auf Okulare bis zum Jahresende

Sale bei Astroshop: https://www.astroshop.de/a,Lagerabverkauf=Ja

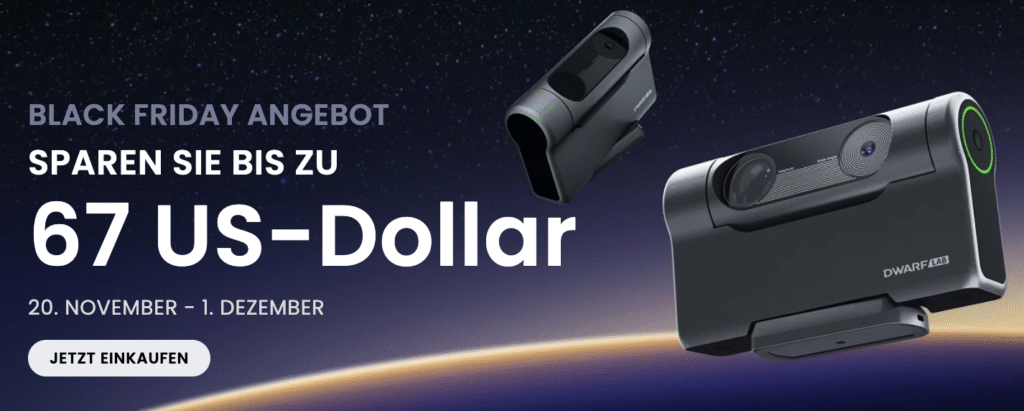

Dwarf Smartteleskop – direkt beim Hersteller mit Rabatt

Oder die wohl unkompliziertere Variante mit 8% Nachlass gegenüber der UVP bei Amazon: https://www.amazon.de/dp/B0FB2ZQS79?tag=sportbuecher-21 (Affiliate Link)

Foto Leistenschneider mit diversen Angeboten:

Bilder/Poster by Fehrpics im Onlienshop

Bilder/Poster by Fehrpics im Onlienshop DAS E-Book über Zeitraffer von Timelapse-Pionier und Entwickler von LRTimelapse

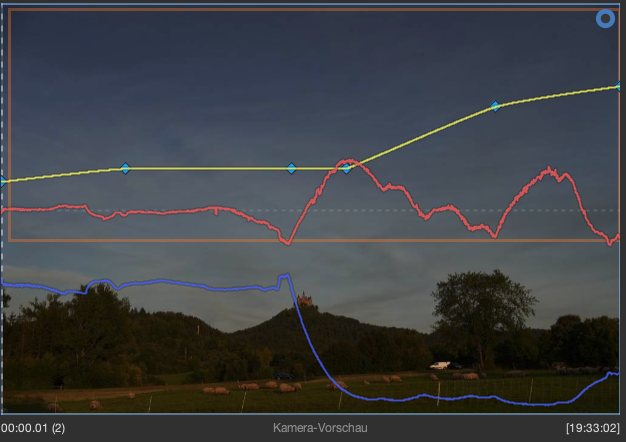

DAS E-Book über Zeitraffer von Timelapse-Pionier und Entwickler von LRTimelapse Der Goldstandard in der Bearbeitung von Zeitraffern – spielend leicht Übergänge & Deflicker realisieren

Der Goldstandard in der Bearbeitung von Zeitraffern – spielend leicht Übergänge & Deflicker realisieren LRTimelapse Pro Timer 3

LRTimelapse Pro Timer 3